6주차 - EKS Security - #1

CloudNet@ 가시다님이 진행하는 AWS EKS Hands-on Study 내용 참고.

기초 이론

배경 : 암호(대칭키/비대칭키), 전자서명, PKI(X.509) 등 이해 필요

- 정보 보안 3요소 : 기밀성(암호화, 액세스 제어..), 무결성(무단 변조 방지), 가용성 - Link

- 액세스 제어(AAA) : 인증(Who?), 인가(What?), 감사 - Link

- [추천 영상] [코맹탈출] RSA 작동원리 - Youtube , [NHN] 웹 서버 인증서 - Youtube

- [생활코딩] 암호학 기초 수업 - Link , 암호 테스트 온라인 사이트 - Link

- Practical Guide to Kubernetes API - Blog

0. 실습 환경 배포 & 소개

☞ Amazon EKS (myeks) 윈클릭 배포 (bastion ec2 2대) & 기본 설정

- bastion ec2 : 운영서버1, 운영서버2

- Amazon EKS (myeks) 윈클릭 배포

# YAML 파일 다운로드

curl -O https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/myeks-6week.yaml

# 변수 지정

CLUSTER_NAME=myeks

SSHKEYNAME=<SSH 키 페이 이름>

MYACCESSKEY=<IAM Uesr 액세스 키>

MYSECRETKEY=<IAM Uesr 시크릿 키>

# CloudFormation 스택 배포

aws cloudformation deploy --template-file myeks-6week.yaml --stack-name $CLUSTER_NAME --parameter-overrides KeyName=$SSHKEYNAME SgIngressSshCidr=$(curl -s ipinfo.io/ip)/32 MyIamUserAccessKeyID=$MYACCESSKEY MyIamUserSecretAccessKey=$MYSECRETKEY ClusterBaseName=$CLUSTER_NAME --region ap-northeast-2

# CloudFormation 스택 배포 완료 후 작업용 EC2 IP 출력

aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text

☞ (옵션) 배포 과정 살펴보기

# 운영서버 EC2 SSH 접속

ssh -i <SSH 키 파일 위치> ec2-user@$(aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text)

ssh -i ~/.ssh/kp-gasida.pem ec2-user@$(aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text)

-------------------------------------------------

#

whoami

pwd

# cloud-init 실행 과정 로그 확인

tail -f /var/log/cloud-init-output.log

# eks 설정 파일 확인

cat myeks.yaml

# cloud-init 정상 완료 후 eksctl 실행 과정 로그 확인

tail -f /root/create-eks.log

#

exit

-------------------------------------------------

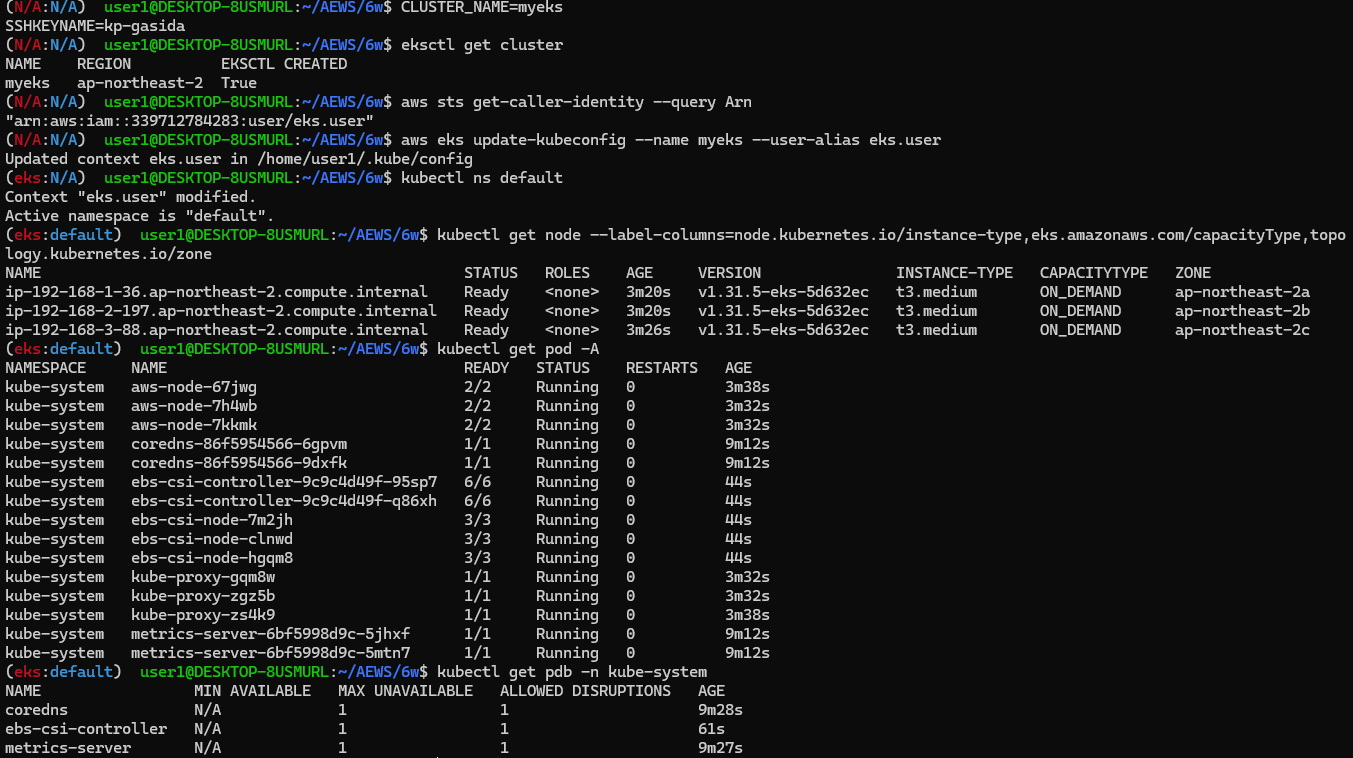

- 자신의 PC에서 AWS EKS 설치 확인 ← 스택 생성 시작 후 20분 후 접속 할 것

# 변수 지정

CLUSTER_NAME=myeks

SSHKEYNAME=kp-gasida

#

eksctl get cluster

# kubeconfig 생성

aws sts get-caller-identity --query Arn

aws eks update-kubeconfig --name myeks --user-alias <위 출력된 자격증명 사용자>

aws eks update-kubeconfig --name myeks --user-alias admin

#

kubectl ns default

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get pod -A

kubectl get pdb -n kube-system

- 노드 IP 정보 확인 및 SSH 접속

# EC2 공인 IP 변수 지정

export N1=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2a" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N2=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2b" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N3=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2c" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

echo $N1, $N2, $N3

# *remoteAccess* 포함된 보안그룹 ID

aws ec2 describe-security-groups --filters "Name=group-name,Values=*remoteAccess*" | jq

export MNSGID=$(aws ec2 describe-security-groups --filters "Name=group-name,Values=*remoteAccess*" --query 'SecurityGroups[*].GroupId' --output text)

# 해당 보안그룹 inbound 에 자신의 집 공인 IP 룰 추가

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr $(curl -s ipinfo.io/ip)/32

# 해당 보안그룹 inbound 에 운영서버 내부 IP 룰 추가

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr 172.20.1.100/32

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr 172.20.1.200/32

# 워커 노드 SSH 접속

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh -o StrictHostKeyChecking=no ec2-user@$i hostname; echo; done

- 운영서버1 EC2 에 SSH 접속 (SSH 키 파일 사용) : AWS EKS 설치 확인 ← 스택 생성 시작 후 20분 후 접속 할 것

# default 네임스페이스 적용

kubectl ns default

# 환경변수 정보 확인

export | egrep 'ACCOUNT|AWS_|CLUSTER|KUBERNETES|VPC|Subnet'

export | egrep 'ACCOUNT|AWS_|CLUSTER|KUBERNETES|VPC|Subnet' | egrep -v 'KEY'

# krew 플러그인 확인 : 보안 관련 플러그인 다수 설치

kubectl krew list

# 인스턴스 정보 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{InstanceID:InstanceId, PublicIPAdd:PublicIpAddress, PrivateIPAdd:PrivateIpAddress, InstanceName:Tags[?Key=='Name']|[0].Value, Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

# 노드 IP 확인 및 PrivateIP 변수 지정

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

N1=$(kubectl get node --label-columns=topology.kubernetes.io/zone --selector=topology.kubernetes.io/zone=ap-northeast-2a -o jsonpath={.items[0].status.addresses[0].address})

N2=$(kubectl get node --label-columns=topology.kubernetes.io/zone --selector=topology.kubernetes.io/zone=ap-northeast-2b -o jsonpath={.items[0].status.addresses[0].address})

N3=$(kubectl get node --label-columns=topology.kubernetes.io/zone --selector=topology.kubernetes.io/zone=ap-northeast-2c -o jsonpath={.items[0].status.addresses[0].address})

echo "export N1=$N1" >> /etc/profile

echo "export N2=$N2" >> /etc/profile

echo "export N3=$N3" >> /etc/profile

echo $N1, $N2, $N3

# 노드 IP 로 ping 테스트

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ping -c 1 $i ; echo; done

- 운영서버2 EC2 에 SSH 접속 (SSH 키 파일 사용) : kind(k8s) 설치 확인 → 위에 별도 실습 내용 참고!

- EKS 배포 후 실습 편의를 위한 설정 : Windows(WSL2) -> 실습 완료 후 삭제할 것.

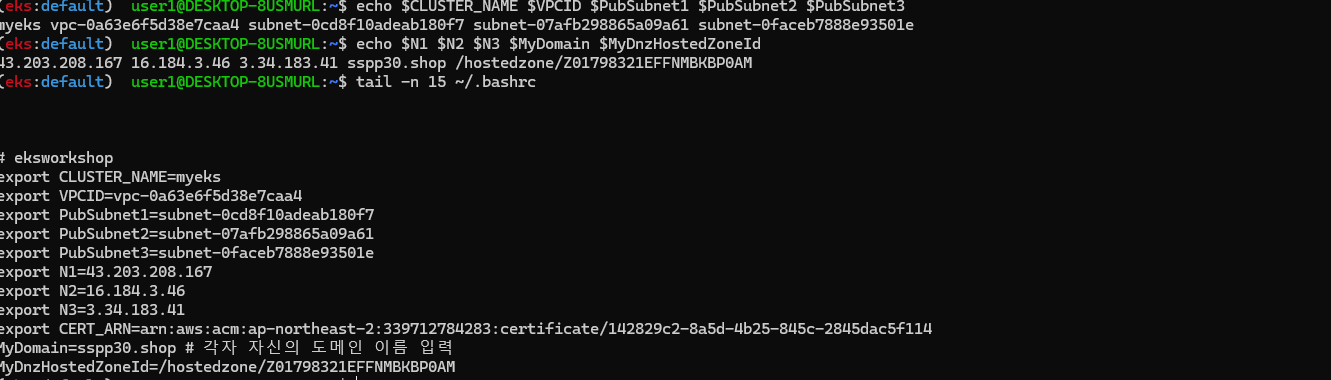

# 변수 지정

export CLUSTER_NAME=myeks

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

export N1=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2a" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N2=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2b" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N3=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2c" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export CERT_ARN=$(aws acm list-certificates --query 'CertificateSummaryList[].CertificateArn[]' --output text) #사용 리전의 인증서 ARN 확인

MyDomain=sspp30.shop # 각자 자신의 도메인 이름 입력

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "$MyDomain." --query "HostedZones[0].Id" --output text)

# 실습 완료 후 삭제 할 것!

cat << EOF >> ~/.bashrc

# eksworkshop

export CLUSTER_NAME=myeks

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

export N1=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2a" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N2=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2b" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N3=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2c" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export CERT_ARN=$(aws acm list-certificates --query 'CertificateSummaryList[].CertificateArn[]' --output text)

MyDomain=sspp30.shop # 각자 자신의 도메인 이름 입력

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "$MyDomain." --query "HostedZones[0].Id" --output text)

EOF

# [신규 터미널] 확인

echo $CLUSTER_NAME $VPCID $PubSubnet1 $PubSubnet2 $PubSubnet3

echo $N1 $N2 $N3 $MyDomain $MyDnzHostedZoneId

tail -n 15 ~/.bashrc

☞ AWS LoadBalancer Controller, ExternalDNS, gp3 storageclass, kube-ops-view(Ingress) 설치

- 설치

# AWS LoadBalancerController

helm repo add eks https://aws.github.io/eks-charts

helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n kube-system --set clusterName=$CLUSTER_NAME \

--set serviceAccount.create=false --set serviceAccount.name=aws-load-balancer-controller

# ExternalDNS

echo $MyDomain

curl -s https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml | MyDomain=$MyDomain MyDnzHostedZoneId=$MyDnzHostedZoneId envsubst | kubectl apply -f -

# gp3 스토리지 클래스 생성

cat <<EOF | kubectl apply -f -

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: gp3

annotations:

storageclass.kubernetes.io/is-default-class: "true"

allowVolumeExpansion: true

provisioner: ebs.csi.aws.com

volumeBindingMode: WaitForFirstConsumer

parameters:

type: gp3

allowAutoIOPSPerGBIncrease: 'true'

encrypted: 'true'

fsType: xfs # 기본값이 ext4

EOF

kubectl get sc

# kube-ops-view

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=ClusterIP --set env.TZ="Asia/Seoul" --namespace kube-system

# kubeopsview 용 Ingress 설정 : group 설정으로 1대의 ALB를 여러개의 ingress 에서 공용 사용

echo $CERT_ARN

cat <<EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

labels:

app.kubernetes.io/name: kubeopsview

name: kubeopsview

namespace: kube-system

spec:

ingressClassName: alb

rules:

- host: kubeopsview.$MyDomain

http:

paths:

- backend:

service:

name: kube-ops-view

port:

number: 8080 # name: http

path: /

pathType: Prefix

EOF

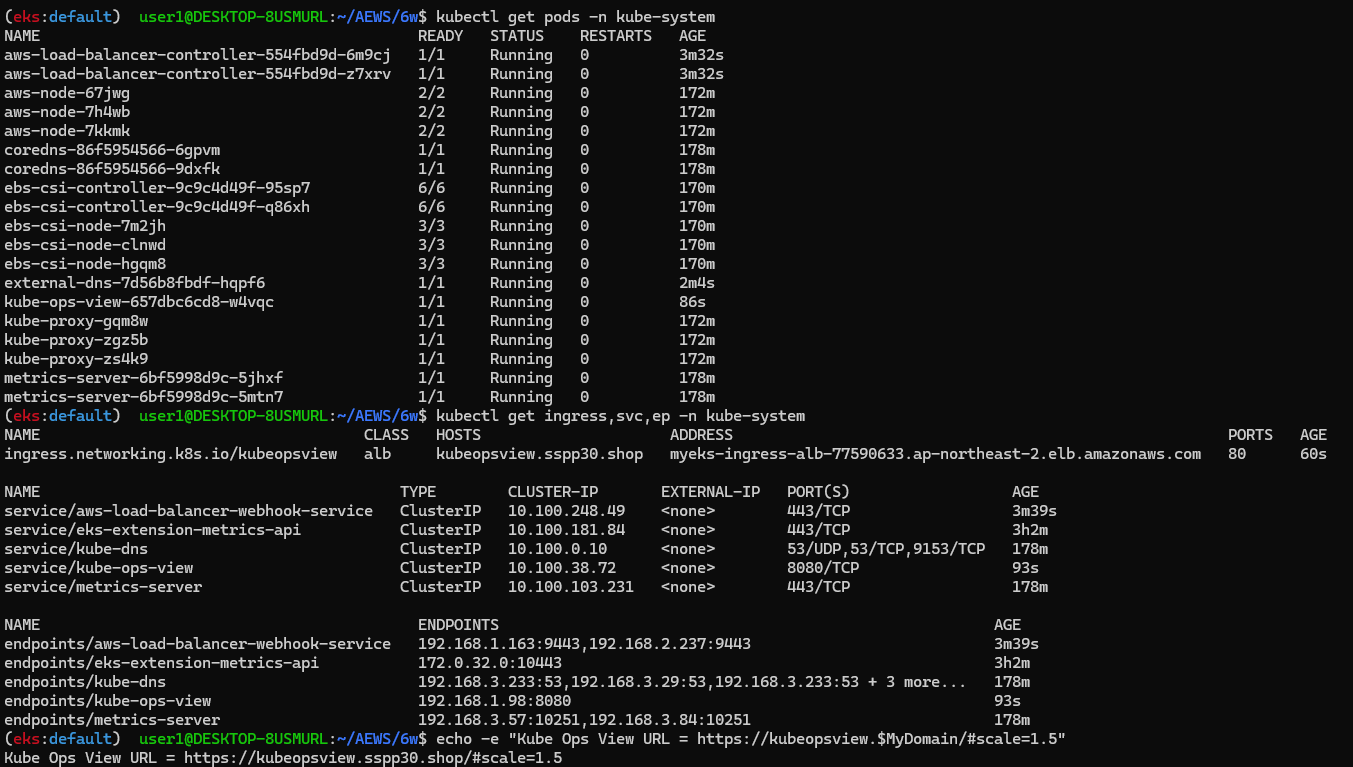

- 확인

# 설치된 파드 정보 확인

kubectl get pods -n kube-system

# service, ep, ingress 확인

kubectl get ingress,svc,ep -n kube-system

# Kube Ops View 접속 정보 확인 : 조금 오래 기다리면 접속됨...

echo -e "Kube Ops View URL = https://kubeopsview.$MyDomain/#scale=1.5"

open "https://kubeopsview.$MyDomain/#scale=1.5" # macOS

☞ 프로메테우스 & 그라파나(admin / prom-operator) 설치 : 대시보드 Import 17900 - Link

# repo 추가

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

# 파라미터 파일 생성 : PV/PVC(AWS EBS) 삭제에 불편하니, 4주차 실습과 다르게 PV/PVC 미사용

cat <<EOT > monitor-values.yaml

prometheus:

prometheusSpec:

scrapeInterval: "15s"

evaluationInterval: "15s"

podMonitorSelectorNilUsesHelmValues: false

serviceMonitorSelectorNilUsesHelmValues: false

retention: 5d

retentionSize: "10GiB"

# Enable vertical pod autoscaler support for prometheus-operator

verticalPodAutoscaler:

enabled: true

ingress:

enabled: true

ingressClassName: alb

hosts:

- prometheus.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

grafana:

defaultDashboardsTimezone: Asia/Seoul

adminPassword: prom-operator

defaultDashboardsEnabled: false

ingress:

enabled: true

ingressClassName: alb

hosts:

- grafana.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

alertmanager:

enabled: false

defaultRules:

create: false

kubeControllerManager:

enabled: false

kubeEtcd:

enabled: false

kubeScheduler:

enabled: false

prometheus-windows-exporter:

prometheus:

monitor:

enabled: false

EOT

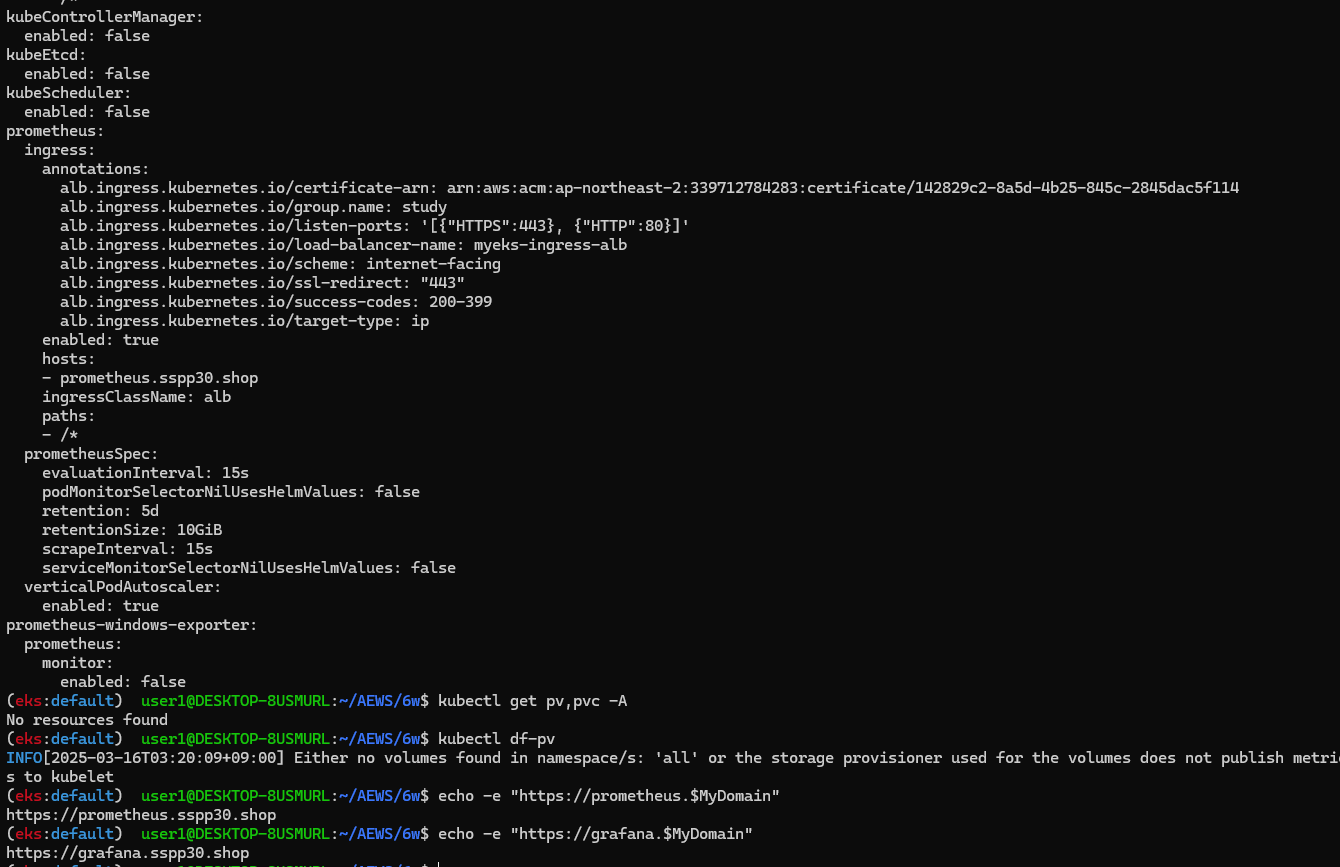

cat monitor-values.yaml

# helm 배포

helm install kube-prometheus-stack prometheus-community/kube-prometheus-stack --version 69.3.1 \

-f monitor-values.yaml --create-namespace --namespace monitoring

# helm 확인

helm get values -n monitoring kube-prometheus-stack

# PV 사용하지 않음

kubectl get pv,pvc -A

kubectl df-pv

# 프로메테우스 웹 접속

echo -e "https://prometheus.$MyDomain"

open "https://prometheus.$MyDomain" # macOS

# 그라파나 웹 접속 : admin / prom-operator

echo -e "https://grafana.$MyDomain"

open "https://grafana.$MyDomain" # macOS

1. K8S 인증/인가

- Controlling Access to the Kubernetes API - Docs

- K8S 인증 : Authenticating* - Docs

- K8S 인증 (X.509) : Certificates and Certificate Signing Requests - Docs

- K8S 인가 : Authorization* - Docs , Using RBAC Authorization - Docs

- EKS 인증/인가

- EKS IRSA & Pod Identity : 파드(Service Account)에 AWS 리소스 사용을 위한 권한 부여 방법

- [악분님] EKS IRSA 등장하기 전, 파드에 권한 부여 방법 - Blog

☞ K8S(API 접근) 인증/인가 : 출처 - 김태민 기술 블로그 - 링크 링크2

- API 서버 사용 : kubectl(config, 다수 클러스터 관리 가능), 서비스 어카운트, https(x.509 Client Certs) ⇒ X.509 발음을 어떻게 하시나요? - 링크

- API 서버 접근 과정 : 인증 → 인가 → Admission Control(API 요청 검증, 필요 시 변형 - 예. ResourceQuota, LimitRange) - 참고

인증(Authentication)

- X.509 Client Certs : kubeconfig 에 CA crt(발급 기관 인증서) , Client crt(클라이언트 인증서) , Client key(클라이언트 개인키) 를 통해 인증

- kubectl : 여러 클러스터(kubeconfig)를 관리 가능 - contexts 에 클러스터와 유저 및 인증서/키 참고

- Service Account : 기본 서비스 어카운트(default) - 시크릿(CA crt 와 token)

인가(Authorization)

- 인가 방식 : RBAC(Role, RoleBinding), ABAC, Webhook, Node Authorization ⇒ RBAC 발음을 어떻게 하시나요?

- RBAC : 역할 기반의 권한 관리, 사용자와 역할을 별개로 선언 후 두가지를 조합(binding)해서 사용자에게 권한을 부여하여 kubectl or API로 관리 가능

- Namespace/Cluster - Role/ClusterRole, RoleBinding/ClusterRoleBinding, Service Account

- Role(롤) - (RoleBinding 롤 바인딩) - Service Account(서비스 어카운트) : 롤 바인딩은 롤과 서비스 어카운트를 연결

- Role(네임스페이스내 자원의 권한) vs ClusterRole(클러스터 수준의 자원의 권한)

☞ .kube/config 파일 내용

- clusters : kubectl 이 사용할 쿠버네티스 API 서버의 접속 정보 목록. 원격의 쿠버네티스 API 서버의 주소를 추가해 사용 가능

- users : 쿠버네티스의 API 서버에 접속하기 위한 사용자 인증 정보 목록. (서비스 어카운트의 토큰, 혹은 인증서의 데이터 등)

- contexts : cluster 항목과 users 항목에 정의된 값을 조합해 최종적으로 사용할 쿠버네티스 클러스터의 정보(컨텍스트)를 설정.

- 예를 들어 clusters 항목에 클러스터 A,B 가 정의돼 있고, users 항목에 사용자 a,b 가 정의돼 있다면 cluster A + user a 를 조합해, 'cluster A 에 user a 로 인증해 쿠버네티스를 사용한다' 라는 새로운 컨텍스트를 정의할 수 있습니다.

- kubectl 을 사용하려면 여러 개의 컨텍스트 중 하나를 선택.

cat .kube/config

apiVersion: v1

clusters:

- cluster:

certificate-authority-data: LS0tLS1CRUdJTiBDRVJUSUZJQ0FURS0tLS0tCk1JSURCVENDQWUyZ0F3SUJBZ0lJRGo5VVhhdUFVQzB3RFFZSktvWklodmNOQVFFTEJRQXdGVEVUTUJFR0ExVUUKQXhNS2EzVmlaWEp1WlhSbGN6QWVGdzB5TlRBek1UVXhOVEEzTkRaYUZ3MHpOVEF6TVRNeE5URXlORFphTUJVeApFekFSQmdOVkJBTVRDbXQxWW1WeWJtVjBaWE13Z2dFaU1BMEdDU3FHU0liM0RRRUJBUVVBQTRJQkR3QXdnZ0VLCkFvSUJBUUMzZXJ4NGhBc1JLZ0EvdmZ1c3R4YkhtNiszTHExZjhyaldVNmliS1dpVzdxcGNpenRwVjlQcGFmZHkKbmdGTHpGejUwRENLWFZUK1dtUGJadG9KdXh4Yk5xN213TzczZkp6T3Y1eTJZZlRPTHdpUlNBeXNZR3pxdVd4WQpyNFRaUVNyd1FQUXRqZ3YzVVFTb1FQcDgyYnl4L3JjWW9WK1N4OTB6ZGloZVRTVXVDY2pRWWRmQldFd1lNdnUwCkJaRmR6anVvZHBVTEVrN3h2MmprcFhHVU02ZTNQYklkMGNIZ0xoemhVREV5MjRlUHI1Zm1oNkVFVkd6NkJSR0MKQkp1ZFE4a1AyV3lKUmRFSFhkaU1CVTZLa2lINDlFWkJaVnpiWUN5OXE0MzhNeDd0Q3BySFoyZWtHWkdCV044QQppTkN1VU8wenR4VzdXcXh4dVgwemJuKzJwZ3VEQWdNQkFBR2pXVEJYTUE0R0ExVWREd0VCL3dRRUF3SUNwREFQCkJnTlZIUk1CQWY4RUJUQURBUUgvTUIwR0ExVWREZ1FXQkJTakdsVGpZdkR3QzVjbnJpVkk4Nm8zajBLSFhUQVYKQmdOVkhSRUVEakFNZ2dwcmRXSmxjbTVsZEdWek1BMEdDU3FHU0liM0RRRUJDd1VBQTRJQkFRQWJOVFJZYXN4cApJNnlJdnF6OVpFaHVBWFhBNEwrTVdPeFp4YU5RNGtyOCtTb1lndXh3dkNoTDg4aGZqMGNrTGxPblh4STJyMUVUCk9hRUdKWFRMZnBYakQraGRVenZMRWJQVmVVc1FkZzlRemFUL2tPeTFaZXJMUDlLMVl6bXR1NktBUC9tdjdWd2EKZkhDcW5XTGdJS3BwQmJuWGkxS3Z2bWwvR3RUTGs2akNuV2M3TkdjQVU4WkhtWjFBd1ZTalJTTHFFUjVqTnY5dwpQd2hhemFWRnhFdHRsWExKMDZBNUdTci9tSU5qWkxOejFhK2c3MlNEVHhmY3pIWVFBRGdGT284alZQOWlKNDcrCm9nNm81M1ZOMVFWL3p1dFFocXJMUDBMTit5b01Nc0VySG1IQWpxZ3ZRQURTOXpqREJGMHNjd2tsaFBaVEFwTnIKLzljVDVmUDY4OUgyCi0tLS0tRU5EIENFUlRJRklDQVRFLS0tLS0K

server: https://FDAFF52CF67728F6C2259CFE7C292369.sk1.ap-northeast-2.eks.amazonaws.com

name: arn:aws:eks:ap-northeast-2:339712784283:cluster/myeks

contexts:

- context:

cluster: arn:aws:eks:ap-northeast-2:339712784283:cluster/myeks

namespace: default

user: eks.user

name: eks.user

current-context: eks.user

kind: Config

preferences: {}

users:

- name: eks.user

user:

exec:

apiVersion: client.authentication.k8s.io/v1beta1

args:

- --region

- ap-northeast-2

- eks

- get-token

- --cluster-name

- myeks

- --output

- json

command: aws

env: null

interactiveMode: IfAvailable

provideClusterInfo: false

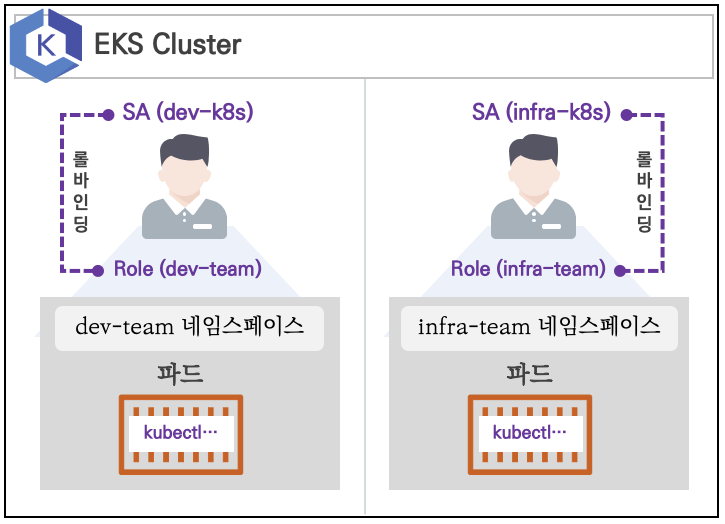

- 실습 환경

- 쿠버네티스에 사용자를 위한 서비스 어카운트(Service Account, SA)를 생성 : dev-k8s, infra-k8s

- 사용자는 각기 다른 권한(Role, 인가)을 가짐 : dev-k8s(dev-team 네임스페이스 내 모든 동작) , infra-k8s(dev-team 네임스페이스 내 모든 동작)

- 각각 별도의 kubectl 파드를 생성하고, 해당 파드에 SA 를 지정하여 권한에 대한 테스트를 진행

☞ 네임스페이스와 서비스 어카운트 생성 후 확인

- 파드 기동 시 서비스 어카운트 한 개가 할당되며, 서비스 어카운트 기반 인증/인가를 함, 미지정 시 기본 서비스 어카운트가 할당

- 서비스 어카운트에 자동 생성된 시크릿에 저장된 토큰으로 쿠버네티스 API에 대한 인증 정보로 사용 할 수 있다 ← 1.23 이전 버전의 경우에만 해당

# 네임스페이스(Namespace, NS) 생성 및 확인

kubectl create namespace dev-team

kubectl create ns infra-team

# 네임스페이스 확인

kubectl get ns

# 네임스페이스에 각각 서비스 어카운트 생성 : serviceaccounts 약자(=sa)

kubectl create sa dev-k8s -n dev-team

kubectl create sa infra-k8s -n infra-team

# 서비스 어카운트 정보 확인

kubectl get sa -n dev-team

kubectl get sa dev-k8s -n dev-team -o yaml

kubectl get sa -n infra-team

kubectl get sa infra-k8s -n infra-team -o yaml

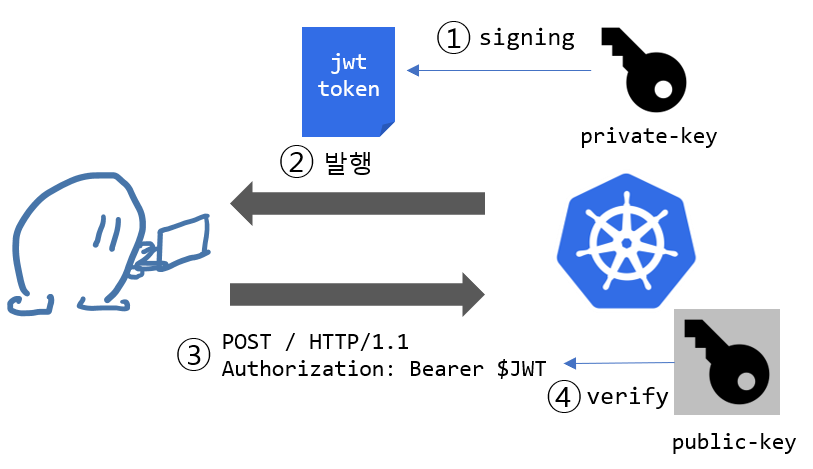

☞ (심화 참고) dev-k8s 서비스어카운트의 토큰 정보 확인 - https://jwt.io/ → Bearer type - JWT(JSON Web Token) - 링크

Bearer type - JWT(JSON Web Token)

- Bearer type 경우, 서버에서 지정한 어떠한 문자열도 입력할 수 있습니다. 하지만 굉장히 허술한 느낌을 받습니다.

- 이를 보완하고자 쿠버네티스에서 Bearer 토큰을 전송할 때 주로 JWT (JSON Web Token) 토큰을 사용합니다.

- JWT는 X.509 Certificate와 마찬가지로 private key를 이용하여 토큰을 서명하고 public key를 이용하여 서명된 메세지를 검증합니다.

- 이러한 메커니즘을 통해 해당 토큰이 쿠버네티스를 통해 생성된 valid한 토큰임을 인증할 수 있습니다.

- X.509 Certificate의 lightweight JSON 버전이라고 생각하면 편리합니다.

- jwt는 JSON 형태로 토큰 형식을 정의한 스펙입니다. jwt는 쿠버네티스에서 뿐만 아니라 다양한 웹 사이트에서 인증, 권한 허가, 세션관리 등의 목적으로 사용합니다.

- Header: 토큰 형식와 암호화 알고리즘을 선언합니다.

- Payload: 전송하려는 데이터를 JSON 형식으로 기입합니다.

- Signature: Header와 Payload의 변조 가능성을 검증합니다.

- 각 파트는 base64 URL 인코딩이 되어서 .으로 합쳐지게 됩니다.

☞ (심화 참고) JWT 소개 추천 영상 - 생활코딩 , 코딩애플

☞ 서비스 어카운트를 지정하여 파드 생성 후 권한 테스트

# 각각 네임스피이스에 kubectl 파드 생성 - 컨테이너이미지

# docker run --rm --name kubectl -v /path/to/your/kube/config:/.kube/config bitnami/kubectl:latest

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: dev-kubectl

namespace: dev-team

spec:

serviceAccountName: dev-k8s

containers:

- name: kubectl-pod

image: bitnami/kubectl:1.31.4

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: infra-kubectl

namespace: infra-team

spec:

serviceAccountName: infra-k8s

containers:

- name: kubectl-pod

image: bitnami/kubectl:1.31.4

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

# 확인

kubectl get pod -A

kubectl get pod -o dev-kubectl -n dev-team -o yaml

serviceAccount: dev-k8s

...

kubectl get pod -o infra-kubectl -n infra-team -o yaml

serviceAccount: infra-k8s

...

# 파드에 기본 적용되는 서비스 어카운트(토큰) 정보 확인

kubectl exec -it dev-kubectl -n dev-team -- ls /run/secrets/kubernetes.io/serviceaccount

kubectl exec -it dev-kubectl -n dev-team -- cat /run/secrets/kubernetes.io/serviceaccount/token

kubectl exec -it dev-kubectl -n dev-team -- cat /run/secrets/kubernetes.io/serviceaccount/namespace

kubectl exec -it dev-kubectl -n dev-team -- cat /run/secrets/kubernetes.io/serviceaccount/ca.crt

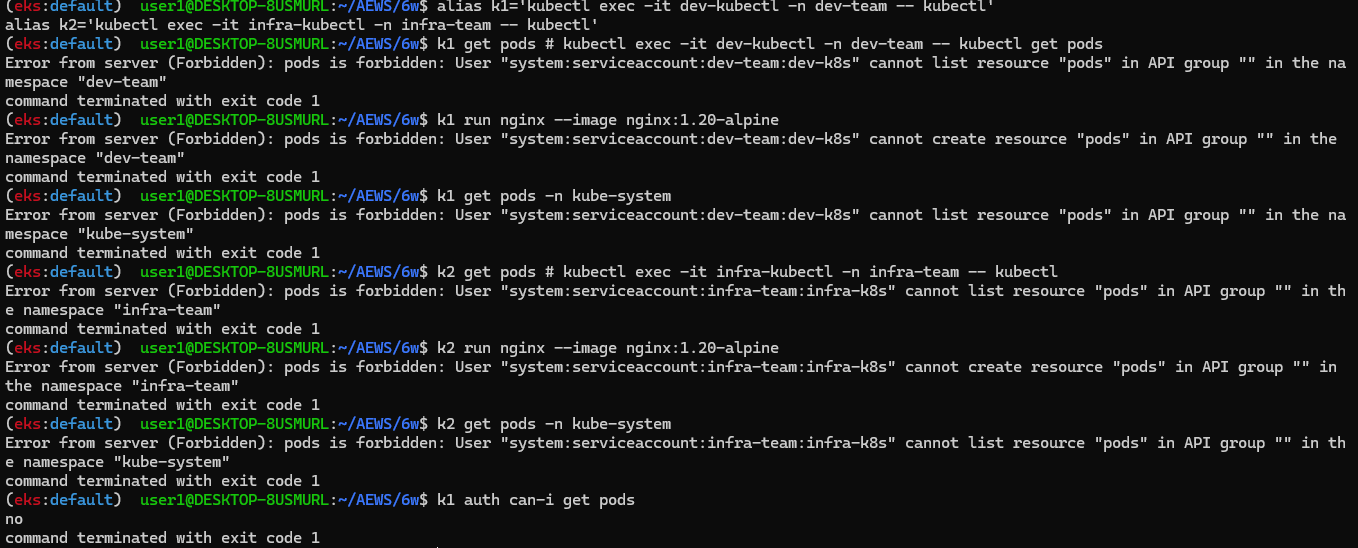

# 각각 파드로 Shell 접속하여 정보 확인 : 단축 명령어(alias) 사용

alias k1='kubectl exec -it dev-kubectl -n dev-team -- kubectl'

alias k2='kubectl exec -it infra-kubectl -n infra-team -- kubectl'

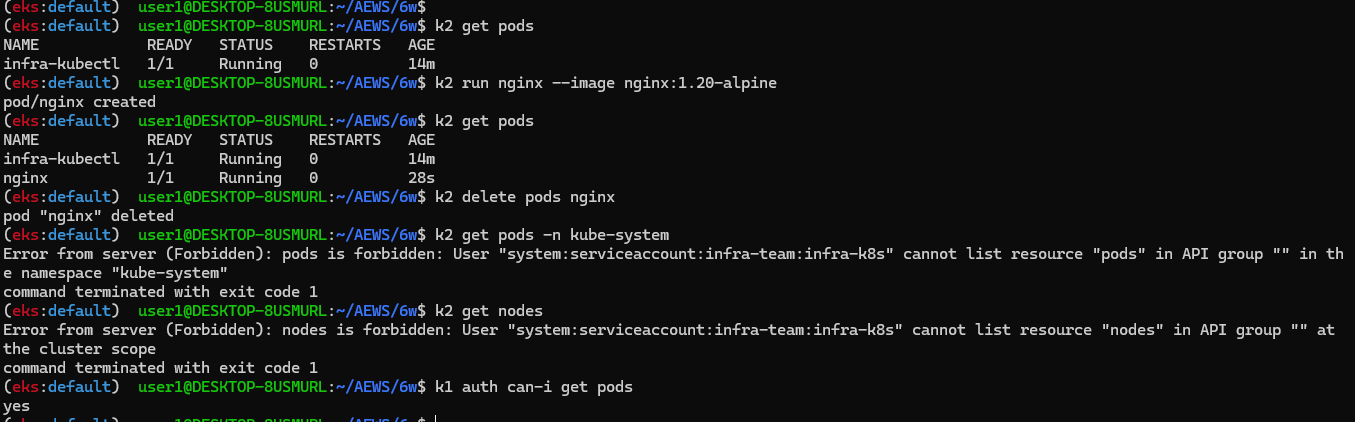

# 권한 테스트

k1 get pods # kubectl exec -it dev-kubectl -n dev-team -- kubectl get pods 와 동일한 실행 명령이다!

k1 run nginx --image nginx:1.20-alpine

k1 get pods -n kube-system

k2 get pods # kubectl exec -it infra-kubectl -n infra-team -- kubectl get pods 와 동일한 실행 명령이다!

k2 run nginx --image nginx:1.20-alpine

k2 get pods -n kube-system

# (옵션) kubectl auth can-i 로 kubectl 실행 사용자가 특정 권한을 가졌는지 확인

k1 auth can-i get pods

no

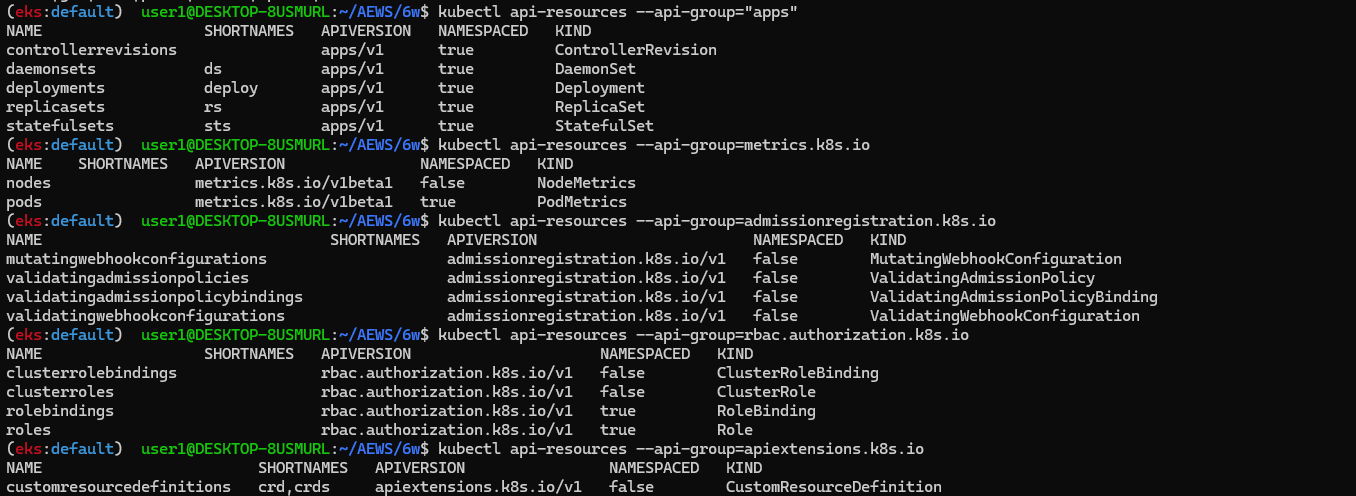

☞ 각각 네임스페이스에 롤(Role)를 생성 후 서비스 어카운트 바인딩*

- 롤(Role) : apiGroups 와 resources 로 지정된 리소스에 대해 verbs 권한을 인가

- 실행 가능한 조작(verbs) : *(모두 처리), create(생성), delete(삭제), get(조회), list(목록조회), patch(일부업데이트), update(업데이트), watch(변경감시)

- Kubernetes API Concepts* - Docs

# Print the supported API resources on the server.

kubectl api-resources

# Print the supported API resources with more information

kubectl api-resources -o wide

# Print the supported API resources with a specific APIGroup

kubectl api-resources --api-group=""

kubectl api-resources --api-group="apps"

kubectl api-resources --api-group=metrics.k8s.io

kubectl api-resources --api-group=admissionregistration.k8s.io

kubectl api-resources --api-group=rbac.authorization.k8s.io

kubectl api-resources --api-group=apiextensions.k8s.io

# 각각 네임스페이스내의 모든 권한에 대한 롤 생성

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: role-dev-team

namespace: dev-team

rules:

- apiGroups: ["*"]

resources: ["*"]

verbs: ["*"]

EOF

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: role-infra-team

namespace: infra-team

rules:

- apiGroups: ["*"]

resources: ["*"]

verbs: ["*"]

EOF

# 롤 확인

kubectl get roles -n dev-team

kubectl get roles -n infra-team

kubectl get roles -n dev-team -o yaml

kubectl describe roles role-dev-team -n dev-team

...

PolicyRule:

Resources Non-Resource URLs Resource Names Verbs

--------- ----------------- -------------- -----

*.* [] [] [*]

# 롤바인딩 생성 : '서비스어카운트 <-> 롤' 간 서로 연동

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: roleB-dev-team

namespace: dev-team

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: role-dev-team

subjects:

- kind: ServiceAccount

name: dev-k8s

namespace: dev-team

EOF

cat <<EOF | kubectl create -f -

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: roleB-infra-team

namespace: infra-team

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: role-infra-team

subjects:

- kind: ServiceAccount

name: infra-k8s

namespace: infra-team

EOF

# 롤바인딩 확인

kubectl get rolebindings -n dev-team

kubectl get rolebindings -n infra-team

kubectl get rolebindings -n dev-team -o yaml

kubectl describe rolebindings roleB-dev-team -n dev-team

...

Role:

Kind: Role

Name: role-dev-team

Subjects:

Kind Name Namespace

---- ---- ---------

ServiceAccount dev-k8s dev-team

- 서비스 어카운트를 지정하여 생성한 파드에서 다시 권한 테스트

# 각각 파드로 Shell 접속하여 정보 확인 : 단축 명령어(alias) 사용

alias k1='kubectl exec -it dev-kubectl -n dev-team -- kubectl'

alias k2='kubectl exec -it infra-kubectl -n infra-team -- kubectl'

# 권한 테스트

k1 get pods

k1 run nginx --image nginx:1.20-alpine

k1 get pods

k1 delete pods nginx

k1 get pods -n kube-system

k1 get pods -n kube-system -v=6

k1 get nodes

k1 get nodes -v=6

k2 get pods

k2 run nginx --image nginx:1.20-alpine

k2 get pods

k2 delete pods nginx

k2 get pods -n kube-system

k2 get nodes

# (옵션) kubectl auth can-i 로 kubectl 실행 사용자가 특정 권한을 가졌는지 확인

k1 auth can-i get pods

yes

- 리소스 삭제 : kubectl delete ns dev-team infra-team

2. EKS 인증/인가

동작 : 사용자/애플리케이션 → k8s 사용 시 ⇒ 인증은 AWS IAM, 인가는 K8S RBAC

추천 영상

- [Youtube] Amazon EKS 마이그레이션 요점정리(강인호) - 링크

- EKS 환경을 더 효율적으로, 더 안전하게 - 신은수 시큐리티 스페셜리스트 솔루션즈 아키텍트, AWS :: AWS Summit Korea 2022 - 링크 PDF

- [AWS Youtube EKS] Securing Kubernetes workloads in Amazon EKS (KUB315) - Link

- [AWS Youtube EKS] Securing Kubernetes workloads in Amazon EKS (CON335) - Link

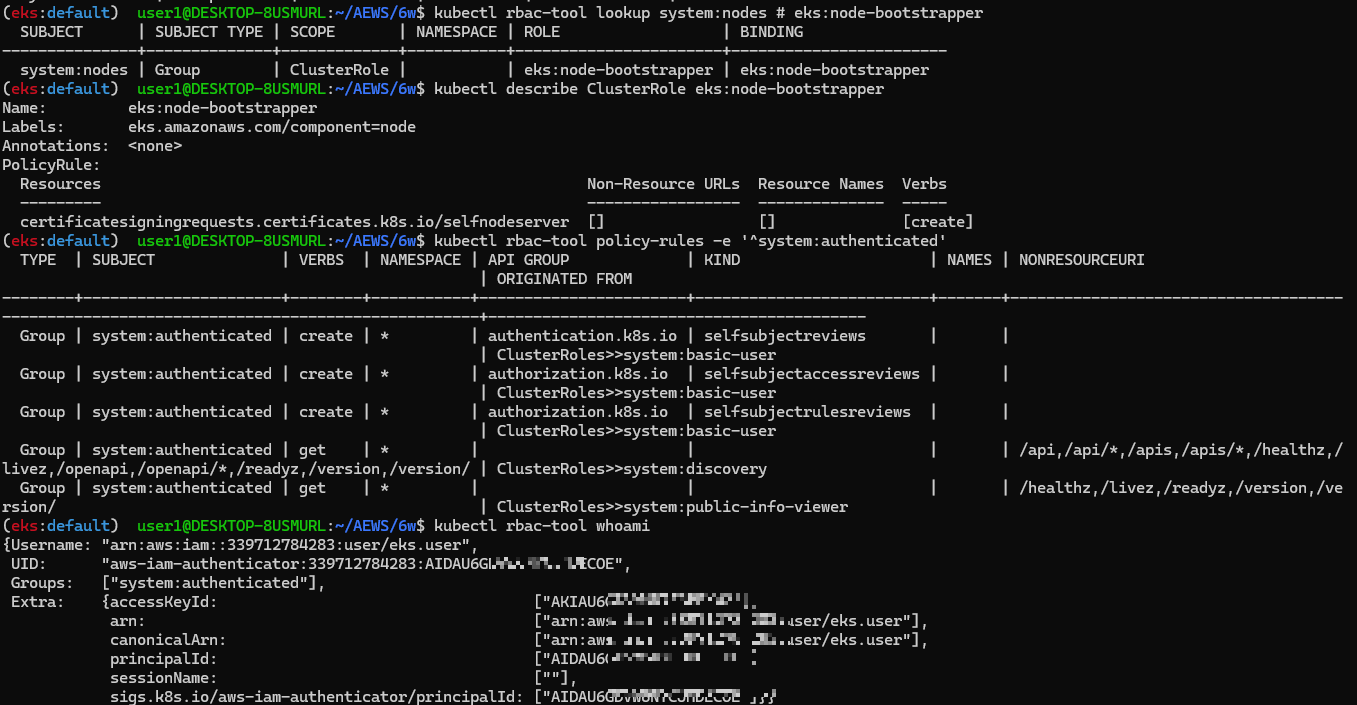

☞ RBAC 관련 krew 플러그인 : [자신의 PC] or [운영서버 1]

- 롤(Role) : apiGroups 와 resources 로 지정된 리소스에 대해 verbs 권한을 인가

- 실행 가능한 조작(verbs) : *(모두 처리), create(생성), delete(삭제), get(조회), list(목록조회), patch(일부업데이트), update(업데이트), watch(변경감시)

| Verbs | HTTP request methods |

| get, watch, list | GET |

| create | POST |

| patch | PATCH |

| update | PUT |

| delete, delete collection | DELETE |

k8s verb mapping to HTTP request methods for CRUD operators

# 설치

kubectl krew install access-matrix rbac-tool rbac-view rolesum whoami

# k8s 인증된 주체 확인

kubectl whoami

arn:aws:iam::9112...:user/admin

# Show an RBAC access matrix for server resources

kubectl access-matrix -h

kubectl access-matrix # Review access to cluster-scoped resources

kubectl access-matrix --namespace default # Review access to namespaced resources in 'default'

# RBAC Lookup by subject (user/group/serviceaccount) name

kubectl rbac-tool -h

kubectl rbac-tool lookup

kubectl rbac-tool lookup system:masters

SUBJECT | SUBJECT TYPE | SCOPE | NAMESPACE | ROLE

+----------------+--------------+-------------+-----------+---------------+

system:masters | Group | ClusterRole | | cluster-admin

kubectl rbac-tool lookup system:nodes # eks:node-bootstrapper

kubectl rbac-tool lookup system:bootstrappers # eks:node-bootstrapper

kubectl describe ClusterRole eks:node-bootstrapper

# RBAC List Policy Rules For subject (user/group/serviceaccount) name

kubectl rbac-tool policy-rules

kubectl rbac-tool policy-rules -e '^system:.*'

kubectl rbac-tool policy-rules -e '^system:authenticated'

# Generate ClusterRole with all available permissions from the target cluster

kubectl rbac-tool show

# Shows the subject for the current context with which one authenticates with the cluster

kubectl rbac-tool whoami

{Username: "arn:aws:iam::339712784283:user/eks.user",

UID: "aws-iam-authenticator:339712784283:AIDAU6GDVW6NYCxxxxxxx",

Groups: ["system:authenticated"],

Extra: {accessKeyId: ["AKIAU6GDVxxxxxx"],

arn: ["arn:aws:iam::339712784283:user/eks.user"],

canonicalArn: ["arn:aws:iam::339712784283:user/eks.user"],

principalId: ["AIDAU6GDxxxxxx"],

sessionName: [""],

sigs.k8s.io/aws-iam-authenticator/principalId: ["AIDAU6GDVWxxxxx]}}

# Summarize RBAC roles for subjects : ServiceAccount(default), User, Group

kubectl rolesum -h

kubectl rolesum aws-node -n kube-system # sa

kubectl rolesum -k User system:kube-proxy # user

kubectl rolesum -k Group system:masters # group

kubectl rolesum -k Group system:nodes

kubectl rolesum -k Group system:authenticated

Policies:

• [CRB] */system:basic-user ⟶ [CR] */system:basic-user

Resource Name Exclude Verbs G L W C U P D DC

selfsubjectaccessreviews.authorization.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖

selfsubjectreviews.authentication.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖

selfsubjectrulesreviews.authorization.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖

• [CRB] */system:discovery ⟶ [CR] */system:discovery

• [CRB] */system:public-info-viewer ⟶ [CR] */system:public-info-viewer

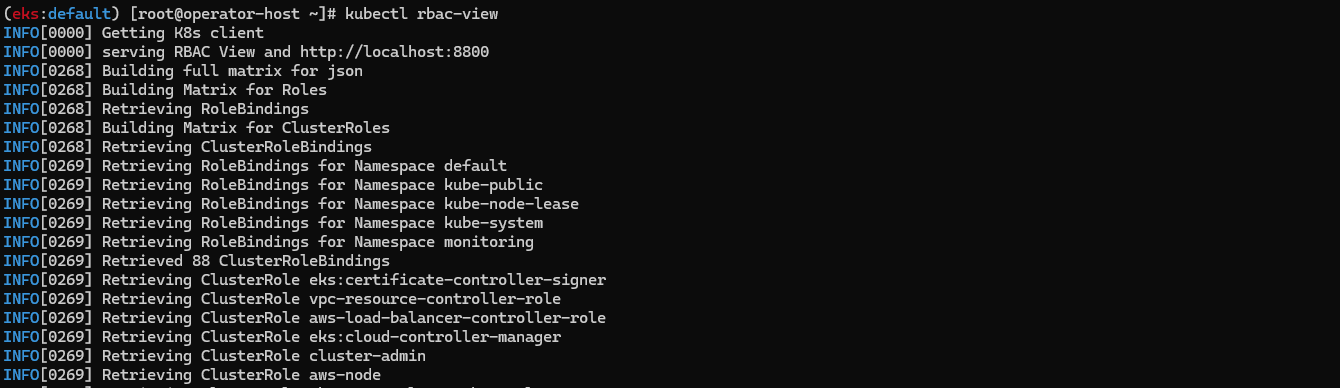

# [운영서버1 EC2 : 터미널1] A tool to visualize your RBAC permissions

kubectl rbac-view

INFO[0000] Getting K8s client

INFO[0000] serving RBAC View and http://localhost:8800

INFO[0268] Building full matrix for json

INFO[0268] Building Matrix for Roles

INFO[0268] Retrieving RoleBindings

INFO[0268] Building Matrix for ClusterRoles

INFO[0268] Retrieving ClusterRoleBindings

.....

## 이후 해당 운영서버1 EC2 공인 IP:8800 웹 접속 : 최초 접속 후 정보 가져오는데 다시 시간 걸림 (2~3분 정도 후 화면 출력됨)

echo -e "RBAC View Web http://$(aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text):8800"

| 약어 | Verbs | 설명 |

| G | Get | 리소스를 조회할 수 있음 (get) |

| L | List | 리소스를 목록으로 나열할 수 있음 (list) |

| W | Watch | 리소스를 감시할 수 있음 (watch) |

| C | Create | 새 리소스를 생성할 수 있음 (create) |

| U | Update | 기존 리소스를 수정할 수 있음 (update) |

| P | Patch | 리소스의 일부를 패치할 수 있음 (patch) |

| D | Delete | 리소스를 삭제할 수 있음 (delete) |

| DC | Delete Collection | 리소스의 컬렉션(여러 개)을 삭제할 수 있음 (deletecollection) |

☞ EKS 인증/인가 확인 : 참고로 aws-auth는 deprecated 예정 - EKS_Docs* , EKS_API*

- 핵심 : 인증은 AWS IAM, 인가는 K8S RBAC에서 처리

1. kubectl 명령 → aws eks get-token → STS에 토큰 요청 ⇒ 응답값 디코드(Pre-Signed URL 이며 GetCallerIdentity..) - 링크

- STS Security Token Service : AWS 리소스에 대한 액세스를 제어할 수 있는 임시 보안 자격 증명(STS)을 생성하여 신뢰받는 사용자에게 제공할 수 있음

- https://ap-northeast-2.console.aws.amazon.com/cloudtrail/home?region=ap-northeast-2#/events?EventSource=sts.amazonaws.com

- AWS CLI 버전 1.16.156 이상에서는 별도 aws-iam-authenticator 설치 없이 aws eks get-token으로 사용 가능 - Docs

# sts caller id의 ARN 확인

aws sts get-caller-identity --query Arn

"arn:aws:iam::<자신의 Account ID>:user/admin"

# kubeconfig 정보 확인

cat ~/.kube/config

...

- name: eks.user

user:

exec:

apiVersion: client.authentication.k8s.io/v1beta1

args:

- --region

- ap-northeast-2

- eks

- get-token

- --cluster-name

- myeks

- --output

- json

command: aws

env: null

interactiveMode: IfAvailable

provideClusterInfo: false

# Get a token for authentication with an Amazon EKS cluster.

# This can be used as an alternative to the aws-iam-authenticator.

aws eks get-token help

# 임시 보안 자격 증명(토큰)을 요청 : expirationTimestamp 시간경과 시 토큰 재발급됨

aws eks get-token --cluster-name $CLUSTER_NAME | jq

aws eks get-token --cluster-name $CLUSTER_NAME | jq -r '.status.token'

aws eks get-token --cluster-name $CLUSTER_NAME --debug | jq

...

2. kubectl의 Client-Go 라이브러리는 Pre-Signed URL을 Bearer Token으로 EKS API Cluster Endpoint로 요청을 보냄

# aws eks get-token --cluster-name $CLUSTER_NAME --debug | jq 출력 내용 아래 부분 확인

DEBUG - Endpoint provider result: https://sts.ap-northeast-2.amazonaws.com

Action=GetCallerIdentity&

Version=2011-06-15&

X-Amz-Algorithm=AWS4-HMAC-SHA256&

X-Amz-Credential=AKIA5ILF.../20230525/ap-northeast-2/sts/aws4_request&

X-Amz-Date=20230525T120720Z&

X-Amz-Expires=60&

X-Amz-SignedHeaders=host;x-k8s-aws-id&

X-Amz-Signature=6e09b846da702767f38c78831986cb558.....

3. EKS API는 Token Review 를 Webhook token authenticator에 요청 ⇒ (STS GetCallerIdentity 호출) AWS IAM 해당 호출 인증 완료 후 User/Role에 대한 ARN 반환

- 참고로 Webhook token authenticator 는 aws-iam-authenticator 를 사용 - 링크 Github

- https://ap-northeast-2.console.aws.amazon.com/cloudtrail/home?region=ap-northeast-2#/events?EventName=GetCallerIdentity

# tokenreviews api 리소스 확인

kubectl api-resources | grep authentication

tokenreviews authentication.k8s.io/v1 false TokenReview

# List the fields for supported resources.

kubectl explain tokenreviews

...

DESCRIPTION:

TokenReview attempts to authenticate a token to a known user. Note:

TokenReview requests may be cached by the webhook token authenticator

plugin in the kube-apiserver.

4. [ConfigMap 방식] 이제 쿠버네티스 RBAC 인가를 처리합니다.

- 해당 IAM User/Role 확인이 되면 k8s aws-auth configmap에서 mapping 정보를 확인하게 됩니다.

- aws-auth 컨피그맵에 'IAM 사용자, 역할 arm, K8S 오브젝트' 로 권한 확인 후 k8s 인가 허가가 되면 최종적으로 동작 실행을 합니다.

- 참고로 EKS를 생성한 IAM principal은 aws-auth 와 상관없이 kubernetes-admin Username으로 system:masters 그룹에 권한을 가짐

- Possible types for an element subjects list in a RoleBinding

| Kind | API Group | Namespace | Description |

| User | rbac.authorization.k8s.io | N/A | name is a reference to a user. |

| Group | rbac.authorization.k8s.io | N/A | name is a reference to a group of users. |

| ServiceAccount | "" | Optional | name is a reference to a ServiceAccount resource in the configured namespace. |

- 시스템 그룹

| roup | Purpose |

| system:unauthenticated | Group assigned to every unauthenticated request |

| system:authenticated | Group assigned to an authenticated user |

| system:masters | Group whose members have unrestricted access to the Kubernetes API server |

| system:serviceaccounts | Group with all ServiceAccounts of the cluster |

| system:serviceaccounts:<namespace> | Group with all ServiceAccounts of this namespace |

- 기본 유저

| Username | Purpose |

| system:anonymous | Represents anonymous requests to the Kubernetes API server |

| system:apiserver | Represents the API server itself |

| system:kube-proxy | Represents process identity of the kube-proxy service |

| system:kube-controller-manager | Represents the user agent of the controller manager |

| system:kube-scheduler | Represents the user of the scheduler |

# aws-auth 컨피그맵 확인 : 현재는 IAM access entry 방식 우선 적용으로 아래 출력 내용과 다를 수 있습니다.

kubectl get cm -n kube-system aws-auth -o yaml

apiVersion: v1

data:

mapRoles: |

- groups:

- system:bootstrappers

- system:nodes

rolearn: arn:aws:iam::339712784283:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts

username: system:node:{{EC2PrivateDNSName}}

kind: ConfigMap

metadata:

creationTimestamp: "2025-03-15T15:22:13Z"

name: aws-auth

namespace: kube-system

resourceVersion: "1961"

uid: 121dc6f3-28a8-4997-a4a7-a1c56d19d66d

#---<아래 생략(추정), ARN은 EKS를 설치한 IAM User , 여기 있었을경우 만약 실수로 삭제 시 복구가 가능했을까?---

mapUsers: |

- groups:

- system:masters

userarn: arn:aws:iam::339712784283:user/eks.user

username: kubernetes-admin

# EKS 설치한 IAM User 정보

kubectl rbac-tool whoami

{Username: "arn:aws:iam::339712784283:user/eks.user",

UID: "aws-iam-authenticator:339712784283:AIDAU6GDVW6NYCJMxxxx",

Groups: ["system:authenticated"],

...

# system:masters , system:authenticated 그룹의 정보 확인

kubectl rbac-tool lookup system:masters

kubectl rbac-tool lookup system:authenticated

kubectl rolesum -k Group system:masters

kubectl rolesum -k Group system:authenticated

# system:masters 그룹이 사용 가능한 클러스터 롤 확인 : cluster-admin

kubectl describe clusterrolebindings.rbac.authorization.k8s.io cluster-admin

Name: cluster-admin

Labels: kubernetes.io/bootstrapping=rbac-defaults

Annotations: rbac.authorization.kubernetes.io/autoupdate: true

Role:

Kind: ClusterRole

Name: cluster-admin

Subjects:

Kind Name Namespace

---- ---- ---------

Group system:masters

# cluster-admin 의 PolicyRule 확인 : 모든 리소스 사용 가능!

kubectl describe clusterrole cluster-admin

Name: cluster-admin

Labels: kubernetes.io/bootstrapping=rbac-defaults

Annotations: rbac.authorization.kubernetes.io/autoupdate: true

PolicyRule:

Resources Non-Resource URLs Resource Names Verbs

--------- ----------------- -------------- -----

*.* [] [] [*]

[*] [] [*]

# system:authenticated 그룹이 사용 가능한 클러스터 롤 확인

kubectl describe ClusterRole system:discovery

kubectl describe ClusterRole system:public-info-viewer

kubectl describe ClusterRole system:basic-user

kubectl describe ClusterRole eks:podsecuritypolicy:privileged

☞ [aws-auth configmap 사용] 데브옵스 신입 사원을 위한 myeks-bastion-2 (운영서버2: operator-host-2)에 설정 해보기

1. [myeks-bastion 운영서버1 or 자신의PC] testuser 사용자 생성

# testuser 사용자 생성

aws iam create-user --user-name testuser

# 사용자에게 프로그래밍 방식 액세스 권한 부여

aws iam create-access-key --user-name testuser

{

"AccessKey": {

"UserName": "testuser",

"AccessKeyId": "AKIAU6GDVW6NVxxxxx",

"Status": "Active",

"SecretAccessKey": "eholMi/mU7fy+/Lcov3LIFzs80T/fxxxxxxxx",

"CreateDate": "2025-03-15T20:09:12+00:00"

}

}

# testuser 사용자에 정책을 추가

aws iam attach-user-policy --policy-arn arn:aws:iam::aws:policy/AdministratorAccess --user-name testuser

# get-caller-identity 확인

aws sts get-caller-identity --query Arn

"arn:aws:iam::911283464785:user/admin"

kubectl whoami

# EC2 IP 확인 : myeks-bastion-EC2-2 PublicIPAdd 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

2. [myeks-bastion-2 운영서버2] testuser 자격증명 설정 및 확인

# 아래 실습 진행을 위해, kind(k8s) 삭제

kind delete cluster --name myk8s

mv ~/.kube/config ~/.kube/config.old

# get-caller-identity 확인 >> 왜 안될까요?

aws sts get-caller-identity --query Arn

# testuser 자격증명 설정

aws configure

AWS Access Key ID [None]: AKIAU6GDVxxxxxx

AWS Secret Access Key [None]: eholMi/mU7fy+/Lcov3LIFzs80T/fxxxxxxxxxx

Default region name [None]: ap-northeast-2

# get-caller-identity 확인

aws sts get-caller-identity --query Arn

"arn:aws:iam::911283464785:user/testuser"

# kubectl 시도 >> testuser도 AdministratorAccess 권한을 가지고 있는데, 실패 이유는?

kubectl get node -v6

ls ~/.kube

3. [myeks-bastion] testuser에 system:masters 그룹 부여로 EKS 관리자 수준 권한 설정

# 방안1 : eksctl 사용 >> iamidentitymapping 실행 시 aws-auth 컨피그맵 작성해줌

# Creates a mapping from IAM role or user to Kubernetes user and groups

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

eksctl create iamidentitymapping --cluster $CLUSTER_NAME --username testuser --group system:masters --arn arn:aws:iam::$ACCOUNT_ID:user/testuser

# 확인

kubectl get cm -n kube-system aws-auth -o yaml

...

# 확인 : 기존에 있는 role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-YYYYY 는 어떤 역할/동작을 하는 걸까요?

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

ARN USERNAME GROUPS ACCOUNT

arn:aws:iam::911283464785:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-LHQ7DWHQQRZJ system:node:{{EC2PrivateDNSName}} system:bootstrappers,system:nodes

arn:aws:iam::911283464785:user/testuser testuser system:masters

4. [myeks-bastion-2] testuser kubeconfig 생성 및 kubectl 사용 확인

# testuser kubeconfig 생성 >> aws eks update-kubeconfig 실행이 가능한 이유는?, 3번 설정 후 약간의 적용 시간 필요

CLUSTER_NAME=myeks

aws eks update-kubeconfig --name $CLUSTER_NAME --user-alias testuser

# 운영서버의 config와 비교해보자

cat ~/.kube/config

# kubectl 사용 확인

kubectl ns default

kubectl get node -v6

# rbac-tool 후 확인 >> 기존 계정과 비교해보자

kubectl rbac-tool whoami

{Username: "testuser",

UID: "aws-iam-authenticator:911283464785:AIDA5ILF2FJIV65KG6RBM",

Groups: ["system:masters",

"system:authenticated"],

Extra: {accessKeyId: ["AKIA5ILF2FJIZJUZSG4D"],

arn: ["arn:aws:iam::911283464785:user/testuser"],

canonicalArn: ["arn:aws:iam::911283464785:user/testuser"],

...

5. [myeks-bastion] testuser 의 Group 변경(system:masters → system:authenticated)으로 RBAC 동작 확인

# 방안2 : 아래 edit로 mapUsers 내용 직접 수정 system:authenticated

kubectl edit cm -n kube-system aws-auth

...

# 확인

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

6. [myeks-bastion-2] testuser kubectl 사용 확인

# 시도

kubectl get node -v6

kubectl api-resources -v5

7. [myeks-bastion]에서 testuser IAM 맵핑 삭제

# testuser IAM 맵핑 삭제

eksctl delete iamidentitymapping --cluster $CLUSTER_NAME --arn arn:aws:iam::$ACCOUNT_ID:user/testuser

# Get IAM identity mapping(s)

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

kubectl get cm -n kube-system aws-auth -o yaml

8. [myeks-bastion-2] testuser kubectl 사용 확인

# 시도

kubectl get node -v6

kubectl api-resources -v5- (참고) aws-auth configmap 샘플

# Please edit the object below. Lines beginning with a '#' will be ignored,

# and an empty file will abort the edit. If an error occurs while saving this file will be

# reopened with the relevant failures.

#

apiVersion: v1

data:

mapRoles: |

- groups:

- system:bootstrappers

- system:nodes

rolearn: arn:aws:iam::111122223333:role/my-role

username: system:node:{{EC2PrivateDNSName}}

- groups:

- eks-console-dashboard-full-access-group

rolearn: arn:aws:iam::111122223333:role/my-console-viewer-role

username: my-console-viewer-role

mapUsers: |

- groups:

- system:masters

userarn: arn:aws:iam::111122223333:user/admin

username: admin

- groups:

- eks-console-dashboard-restricted-access-group

userarn: arn:aws:iam::444455556666:user/my-user

username: my-user

☞ EC2 Instance Profile(IAM Role)에 맵핑된 k8s rbac 확인 해보기

1. 노드 mapRoles 확인

# 노드에 STS ARN 정보 확인 : Role 뒤에 인스턴스 ID!

for node in $N1 $N2 $N3; do ssh ec2-user@$node aws sts get-caller-identity --query Arn; done

"arn:aws:sts::911283464785:assumed-role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-LHQ7DWHQQRZJ/i-07c9162ed08d23e6f"

"arn:aws:sts::911283464785:assumed-role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-LHQ7DWHQQRZJ/i-00d9d24c0af0d6815"

"arn:aws:sts::911283464785:assumed-role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-LHQ7DWHQQRZJ/i-031e672f89572abe8"

# aws-auth 컨피그맵 확인 >> system:nodes 와 system:bootstrappers 의 권한은 어떤게 있는지 찾아보세요!

# username 확인! 인스턴스 ID? EC2PrivateDNSName?

kubectl describe configmap -n kube-system aws-auth

...

mapRoles:

----

- groups:

- system:bootstrappers

- system:nodes

rolearn: arn:aws:iam::339712784283:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts

username: system:node:{{EC2PrivateDNSName}}

...

# Get IAM identity mapping(s)

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

ARN USERNAME GROUPS ACCOUNT

arn:aws:iam::339712784283:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts system:node:{{EC2PrivateDNSName}} system:bootstrappers,system:nodes

...

2. awscli 파드를 추가하고, 해당 노드(EC2)의 IMDS 정보 확인 : AWS CLI v2 파드 생성 - 링크 , 공식이미지링크

# awscli 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: awscli-pod

spec:

replicas: 2

selector:

matchLabels:

app: awscli-pod

template:

metadata:

labels:

app: awscli-pod

spec:

containers:

- name: awscli-pod

image: amazon/aws-cli

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

# 파드 생성 확인

kubectl get pod -owide

# 파드 이름 변수 지정

APODNAME1=$(kubectl get pod -l app=awscli-pod -o jsonpath="{.items[0].metadata.name}")

APODNAME2=$(kubectl get pod -l app=awscli-pod -o jsonpath="{.items[1].metadata.name}")

echo $APODNAME1, $APODNAME2

# awscli 파드에서 EC2 InstanceProfile(IAM Role)의 ARN 정보 확인

kubectl exec -it $APODNAME1 -- aws sts get-caller-identity --query Arn

kubectl exec -it $APODNAME2 -- aws sts get-caller-identity --query Arn

# awscli 파드에서 EC2 InstanceProfile(IAM Role)을 사용하여 AWS 서비스 정보 확인 >> 별도 IAM 자격 증명이 없는데 어떻게 가능한 것일까요?

# > 최소권한부여 필요!!! >>> 보안이 허술한 아무 컨테이너나 탈취 시, IMDS로 해당 노드의 IAM Role 사용 가능!

kubectl exec -it $APODNAME1 -- aws ec2 describe-instances --region ap-northeast-2 --output table --no-cli-pager

kubectl exec -it $APODNAME2 -- aws ec2 describe-vpcs --region ap-northeast-2 --output table --no-cli-pager

# EC2 메타데이터 확인 : IDMSv1은 Disable, IDMSv2 활성화 상태, IAM Role - 링크

kubectl exec -it $APODNAME1 -- bash

-----------------------------------

아래부터는 파드에 bash shell 에서 실행

curl -s http://169.254.169.254/ -v

...

# Token 요청

curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600" ; echo

curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600" ; echo

# Token을 이용한 IMDSv2 사용

TOKEN=$(curl -s -X PUT "http://169.254.169.254/latest/api/token" -H "X-aws-ec2-metadata-token-ttl-seconds: 21600")

echo $TOKEN

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/ ; echo

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/latest/ ; echo

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/latest/meta-data/iam/security-credentials/ ; echo

# 위에서 출력된 IAM Role을 아래 입력 후 확인

curl -s -H "X-aws-ec2-metadata-token: $TOKEN" –v http://169.254.169.254/latest/meta-data/iam/security-credentials/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts

{

"Code" : "Success",

"LastUpdated" : "2025-03-15T21:05:36Z",

"Type" : "AWS-HMAC",

"AccessKeyId" : "ASIAU6GDVW6NTRxxxxxxx",

"SecretAccessKey" : "/OiKrhUjqnREKUxQ1eGLV6WIfNHwgxxxxxxxxxx",

"Token" : "IQoJb3JpZ2luX2VjEMX//////////wEaDmFwLW5vcnRoZWFzdC0yIkYwRAIfbAz2HbGJ+yLE1S6K/zTFrjjE7Ggad3b52RCC8Ti+8wIhAJcFW4h6b/j2HrgSPWCKnmgYWa5uYxKK9NgiPWSvKs1dKssFCB4QABoMMzM5NzEyNzg0MjgzIgxwAgf6ctenhJuB5YUqqAUJNCzKovQU2QSQW83UPq68/GWa7u/QV0/c8izZkeQnrxsK0X6iQ5VaCzFUdDc93QKJ2nnpviGJ1x0fdqpcCe5rFSH2qoEST/H5PF7/ipVng5t0ys19bzKN95v04VgX79dMctQyXV+gw8p/d15hfd/QmBJ6SN0sXw2X6TFcJKjcfB6unVzKR+hwDW2AP6AfYJekM7QSrpA7OP0YL93MH7hGDMNm1LY7Pd5Uv0wZrTvKPJQnDUTUCizAzMpICiruqWky+ykUAcMBhQhhwI0YwMkPjr4HpuVBSUnudR3IfmPxut+7CPxnWt7YzIZuj45kjqanxntXoks/szRTLlYZcUgM2oTf1KoSO7KFrtk+51+vjR+nm36cZ7ocToI/n2GBAk6FDoFVBFCLmsXF5Eqo2JCQ54eJ6tCnaVeiAiN0YCqLeDTMHnGT3PDtfq3qVxLY4YcduNNElnJ4zBiXRO8o2OubnliK6VNuq9Rqs/XE3jQqmJnRgduxJrh+ZFGlKMxC9347IAEhcg+cgTwsA823PyRqb0iYuoLQUzlhqVxfJTb8tThnJUYlYMlXvEy2KdtAOwQrn7T4aQm2+8n/DT4v+jl7ihKRFuhuVMBw/DalQdsmDKljAtNUAWkBCwk20kc20ckdJu6n3LD++NSL4NtbHmBZdVVzs8UXipJO1eabdQzDMMf3QuGCGQsift3S/9x/aLyVeMLz4NJESNXEcGf/FnWRuFRTvLgbwdxK+4AecqFw9DM/KpjSUT01xJhTVByNh/p4Ky4PhKkcCAlwt/3avs82xrnPz+zsPtplk/Jew+rysKJBTYscBoNbKEkQbXoFKBmPjHj/Yb6BeBigi1HrYEEZKKeeDiv13aQvMNbxSxJA5nq5psK3NAQKuBTmf0DRFjp2PMMJ4WQbCDC419e+BjqyAXigPIm2gWYxVYPhTRmS6kan90/KKbzNWpzRlfLMWIURTz30GmW70BxCIdOa9w5+r8HAbooPpW0TkAWOlTPQBSbOUKrwTClPd88EqNGfi/Jl6PuxsBJui/oXTHAanRlCTaQ3P3ij5r0eA35pmzBAwp7xfmOl3XFJglQXpaD/enGjxSqHwBOmaDu/XNiM+7B4JAlagmC/hX1mD9I1QaWmLsE1+LQNpfdUHIGLE39OqhkNkK4=",

"Expiration" : "2025-03-16T03:18:09Z"

}

## 출력된 정보는 AWS API를 사용할 수 있는 어느곳에서든지 Expiration 되기전까지 사용 가능

# 파드에서 나오기

exit

---

- 워커 노드에 연결된 IAM 역할(정책)을 관리콘솔에서 확인해보자

3. awscli 파드에 kubeconfig (mapRoles) 정보 생성 및 확인

# node 의 IAM Role ARN을 변수로 지정

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

NODE_ROLE=<각자 자신의 노드 Role 이름>

NODE_ROLE=eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts

# awscli 파드에서 kubeconfig 정보 생성 및 확인 >> kubeconfig 에 정보가 기존 iam user와 차이점은?

kubectl exec -it $APODNAME1 -- aws eks update-kubeconfig --name $CLUSTER_NAME --role-arn $NODE_ROLE

kubectl exec -it $APODNAME1 -- cat /root/.kube/config

...

- --role

- eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts

kubectl exec -it $APODNAME2 -- aws eks update-kubeconfig --name $CLUSTER_NAME --role-arn $NODE_ROLE

kubectl exec -it $APODNAME2 -- cat /root/.kube/config

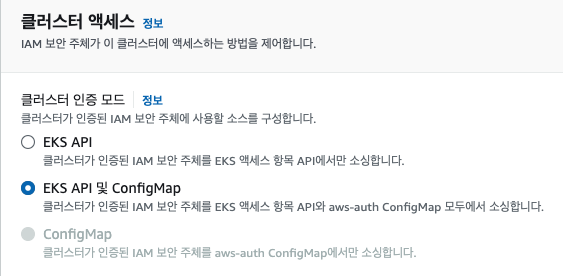

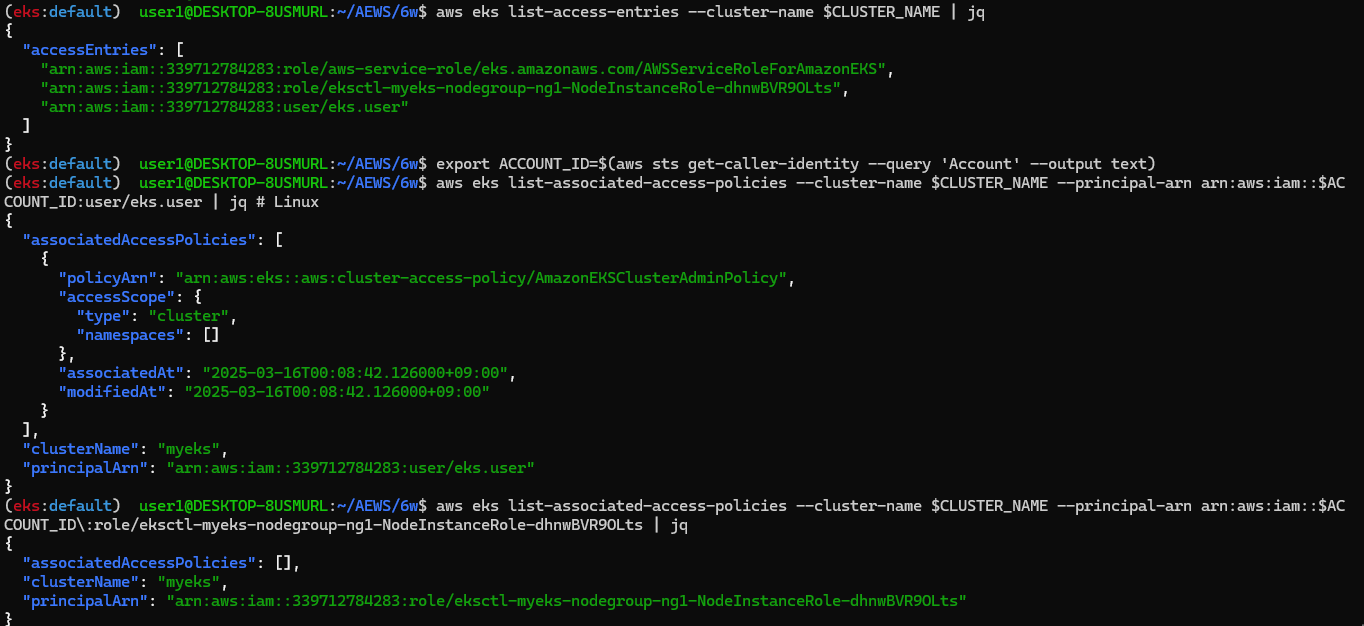

☞ [신기능] A deep dive into simplified Amazon EKS access management controls - Link & Access Management - Link , KrBlog*

- EKS → 액세스 : IAM 액세스 항목

- EKS → 액세스 구성 모드 확인 : EKS API 및 ConfigMap ← 정책 중복 시 EKS API 우선되며 ConfigMap은 무시됨

- 기본 정보 확인 : access policy, access entry, associated-access-policy - Link , Docs , User-facing_roles , AccessPolicy*

# EKS API 액세스모드로 변경

aws eks update-cluster-config --name $CLUSTER_NAME --access-config authenticationMode=API

# List all access policies : 클러스터 액세스 관리를 위해 지원되는 액세스 정책

# https://docs.aws.amazon.com/eks/latest/userguide/access-policy-permissions.html

## AmazonEKSClusterAdminPolicy – 클러스터 관리자

## AmazonEKSAdminPolicy – 관리자

## AmazonEKSEditPolicy – 편집

## AmazonEKSViewPolicy – 보기

...

aws eks list-access-policies | jq

# 맵핑 클러스터롤 정보 확인

kubectl get clusterroles -l 'kubernetes.io/bootstrapping=rbac-defaults' | grep -v 'system:'

NAME CREATED AT

admin 2025-03-15T15:13:20Z

cluster-admin 2025-03-15T15:13:20Z

edit 2025-03-15T15:13:20Z

view 2025-03-15T15:13:20Z

kubectl describe clusterroles admin

kubectl describe clusterroles cluster-admin

kubectl describe clusterroles edit

kubectl describe clusterroles view

#

aws eks list-access-entries --cluster-name $CLUSTER_NAME | jq

{

"accessEntries": [

"arn:aws:iam::911283...:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-t4MD9Py4ZCyK",

"arn:aws:iam::911283...:user/admin"

]

}

# 확인 : macOS - 뒤에 admin 은 자신의 IAM User로 변경해서 실행 할 것!

# export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

# aws eks list-associated-access-policies --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID\:user/admin | jq # macOS

# 확인 : Linux (운영서버, WSL2 등) - 뒤에 admin 은 자신의 IAM User로 변경해서 실행 할 것!

export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

aws eks list-associated-access-policies --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/eks.user | jq # Linux

{

"associatedAccessPolicies": [

{

"policyArn": "arn:aws:eks::aws:cluster-access-policy/AmazonEKSClusterAdminPolicy",

"accessScope": {

"type": "cluster",

"namespaces": []

},

"associatedAt": "2024-04-06T14:53:36.982000+09:00",

"modifiedAt": "2024-04-06T14:53:36.982000+09:00"

}

],

"clusterName": "myeks",

"principalArn": "arn:aws:iam::91128...:user/admin"

}

# 위에서 출력된 nodegroup IAM Role ARN 을 아래 입력 해서 실행 할 것!

aws eks list-associated-access-policies --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID\:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts | jq

aws eks list-associated-access-policies --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts | jq

{

"associatedAccessPolicies": [],

"clusterName": "myeks",

"principalArn": "arn:aws:iam::339712784283:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts"

}

#

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID\:user/eks.user | jq

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/eks.user | jq

...

"kubernetesGroups": [],

...

"username": "arn:aws:iam::339712784283:user/eks.user",

"type": "STANDARD"

...

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID\:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts | jq

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:role/eksctl-myeks-nodegroup-ng1-NodeInstanceRole-dhnwBVR9OLts | jq

...

"kubernetesGroups": [

"system:nodes"

...

"username": "system:node:{{EC2PrivateDNSName}}",

"type": "EC2_LINUX"

...

- testuser 설정

# testuser 의 access entry 생성

aws eks create-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser

aws eks list-access-entries --cluster-name $CLUSTER_NAME | jq -r .accessEntries[]

# testuser에 AmazonEKSClusterAdminPolicy 연동

aws eks associate-access-policy --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser \

--policy-arn arn:aws:eks::aws:cluster-access-policy/AmazonEKSClusterAdminPolicy --access-scope type=cluster

#

aws eks list-associated-access-policies --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser | jq

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser | jq

- [myeks-bastion-2]에서 testuser로 확인

# testuser 정보 확인

aws sts get-caller-identity --query Arn

kubectl whoami

# kubectl 시도

kubectl get node -v6

kubectl api-resources -v5

kubectl rbac-tool whoami

kubectl auth can-i delete pods --all-namespaces

kubectl get cm -n kube-system aws-auth -o yaml

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

- Access entries and Kubernetes groups - Link

# 기존 testuser access entry 제거

aws eks delete-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser

aws eks list-access-entries --cluster-name $CLUSTER_NAME | jq -r .accessEntries[]

#

cat <<EoF> ~/pod-viewer-role.yaml

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: pod-viewer-role

rules:

- apiGroups: [""]

resources: ["pods"]

verbs: ["list", "get", "watch"]

EoF

cat <<EoF> ~/pod-admin-role.yaml

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: pod-admin-role

rules:

- apiGroups: [""]

resources: ["pods"]

verbs: ["*"]

EoF

kubectl apply -f ~/pod-viewer-role.yaml

kubectl apply -f ~/pod-admin-role.yaml

#

kubectl create clusterrolebinding viewer-role-binding --clusterrole=pod-viewer-role --group=pod-viewer

kubectl create clusterrolebinding admin-role-binding --clusterrole=pod-admin-role --group=pod-admin

#

aws eks create-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser --kubernetes-group pod-viewer

...

"accessEntry": {

"clusterName": "myeks",

"principalArn": "arn:aws:iam::91128...:user/testuser",

"kubernetesGroups": [

"pod-viewer"

],

#

aws eks list-associated-access-policies --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser | jq

...

"kubernetesGroups": [

"pod-viewer"

],

...

- [myeks-bastion-2]에서 testuser로 확인

# testuser 정보 확인

aws sts get-caller-identity --query Arn

kubectl whoami

# kubectl 시도

kubectl get pod -v6

kubectl api-resources -v5

kubectl auth can-i get pods --all-namespaces

kubectl auth can-i delete pods --all-namespaces

- kubernetesGroups 업데이트 적용

#

aws eks update-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser --kubernetes-group pod-admin | jq -r .accessEntry

...

"kubernetesGroups": [

"pod-admin"

...

aws eks describe-access-entry --cluster-name $CLUSTER_NAME --principal-arn arn:aws:iam::$ACCOUNT_ID:user/testuser | jq

...

"kubernetesGroups": [

"pod-admin"

],

...

- [myeks-bastion-2]에서 testuser로 확인

# testuser 정보 확인

aws sts get-caller-identity --query Arn

kubectl whoami

# kubectl 시도

kubectl get pod -v6

kubectl api-resources -v5

kubectl auth can-i get pods --all-namespaces

kubectl auth can-i delete pods --all-namespaces

- Migrate from ConfigMap to access entries - Link